Por Morey J. Haber, Asesor Principal de Seguridad de BeyondTrust

Imagina unirte a una videollamada con tu director ejecutivo y descubrir después que el participante era en realidad una falsificación generada por IA. Bienvenido al nuevo campo de batalla digital.

La IA adversarial y las deepfakes han creado una superficie de ataque a la identidad que no es solo digital, sino que también se basa en la propia realidad. Estas tecnologías ya no son ciencia ficción ni teóricas. Se utilizan activamente para suplantar identidades, manipular percepciones políticas y eludir incluso las mejores iniciativas de formación en ciberseguridad.

Si tus defensas de ciberseguridad se basan únicamente en la percepción humana, el reconocimiento de voz o incluso la evidencia visual, eres vulnerable a un ataque.

Del gato y el ratón al juego de la máquina contra la máquina

La ciberseguridad siempre ha sido un juego del gato y el ratón. Como defensores (ratones), históricamente hemos sido capaces de adaptar nuestras defensas al phishing, el malware, el ransomware y las amenazas internas. Hoy, también estamos desarrollando estrategias contra amenazas emergentes, desde la inteligencia artificial (IA) hasta el descifrado cuántico. En este caso, el gato ya no es solo astuto. Los actores de amenazas actuales pueden ser sintéticos, autodidactas, diabólicos y manipuladores de maneras que jamás imaginamos.

Imagina recibir un mensaje de voz de tu director ejecutivo autorizando una transferencia bancaria o una videollamada en vivo de tu administrador de TI pidiéndote que desactives la autenticación multifactor (MFA). Cuando los actores de amenazas utilizan deepfakes de un empleado real como parte de un ataque de ingeniería social, no solo te están engañando, sino que eres «cómplice». Un error en este caso significa que estás permitiendo que se realice una transacción o autenticación no autorizada dentro de tu propia organización.

Qué significan la IA adversaria y los deepfakes para la seguridad

Para evaluar el alcance de esta amenaza, analicemos algunos conceptos clave.

IA adversarial

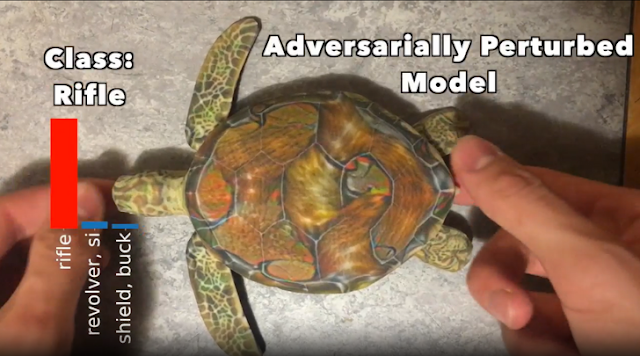

La IA adversarial se refiere a técnicas que manipulan deliberadamente los modelos de IA, como la generación de imágenes/videos o el procesamiento del lenguaje, para crear contenido con una intención o resultado malicioso. Por ejemplo, considera un software de reconocimiento de imágenes que es engañado para que vea una tortuga como un arma basándose en la forma en que se construye la imagen. Como humanos, vemos una tortuga, pero para el software de IA, este ve un arma basándose en los colores, el estilo, la pixelación y el diseño de la imagen.

LabSix demostró cómo los ejemplos adversariales pueden perturbar las entradas para causar una clasificación errónea específica en redes neuronales. En este caso, la red neuronal clasificó una tortuga impresa en 3D como un rifle.

En ciberseguridad, el contenido de IA adversarial puede eludir los filtros de spam, confundir a los motores de detección de malware o evadir la detección de fraude al introducir entradas manipuladoras precisas para confundir a los sistemas de IA.

Ataques de deepfake

Los deepfakes son grabaciones de audio o video alteradas de humanos generadas por modelos de aprendizaje automático (normalmente GAN, Redes Generativas Antagónicas), a menudo utilizadas con fines maliciosos. Un deepfake puede hacer que alguien parezca decir o hacer algo que no es real. Lo que antes era una novedad en redes sociales, el uso de filtros, ahora se ha convertido en un arma para la ingeniería social, el fraude, el soborno, la sextorsión y el chantaje.

Cinco ataques deepfake reales

Considere los siguientes vectores de ataque deepfake bien documentados:

1. Suplantación de la identidad de ejecutivos

Los actores de amenazas utilizan tecnología deepfake para clonar la voz de un ejecutivo o líder político mediante breves muestras de audio obtenidas de fuentes públicas. Luego, usan la tecnología deepfake para llamar a los empleados y solicitar transferencias urgentes de fondos o tarjetas de regalo. También pueden dar instrucciones inapropiadas o pedirles que compartan información confidencial. Estos ataques son una extensión del phishing de voz (vishing) y tienen una mayor probabilidad de éxito a través del ancho de banda limitado de un teléfono; suenan auténticos.

2. Falsificación de videollamadas en vivo

La renderización en tiempo real ya es posible en los sistemas modernos. Los cibercriminales están utilizando esta capacidad para hacerse pasar por colegas o contratistas de confianza a través de Zoom, Teams, FaceTime o Slack. Los deepfakes generados de esta manera parecen convincentemente reales e imitan gestos humanos, como parpadeos, labios en movimiento, cejas levantadas e incluso algunos movimientos de manos. Los resultados parecen aterradoramente reales, especialmente con un ancho de banda bajo o en dispositivos con pantallas pequeñas.

Esta técnica de ataque estuvo detrás de la notoria estafa del director financiero deepfake de Hong Kong, donde cibercriminales falsificaron una videoconferencia web completa, haciéndose pasar por un destacado director financiero y otros participantes de la reunión para, mediante ingeniería social, lograr que la víctima transfiriera 25,6 millones de dólares a cinco cuentas bancarias diferentes de Hong Kong.

3. Integración de malware en medios

El malware puede incrustarse en imágenes, archivos PDF, páginas web y otro contenido deepfake, lo que potencialmente le permite evadir las herramientas antivirus y los sistemas de detección de anomalías. Los actores de amenazas no necesitan usar la fuerza bruta para acceder, simplemente explotan la curiosidad humana para abrir la puerta a Infostealers y otros ataques. Estos ataques generalmente explotan vulnerabilidades en las soluciones utilizadas para mostrar contenido o tienen nombres de archivo falsificados que pueden ejecutar ejecutables.

4. Implementación de chatbots de IA para phishing

Los atacantes implementan bots de phishing basados en IA que simulan ser representantes de atención al cliente en sitios web fraudulentos (sitios web que parecen representar a una empresa real, pero son fraudulentos). El objetivo es manipular a los usuarios para que proporcionen sus credenciales de inicio de sesión (incluida la autenticación multifactor) o desactiven la configuración de seguridad cuando interactúan con el sitio web falso.

5. Falsificación de datos biométricos digitales

Las huellas dactilares sintéticas, los modelos faciales en 3D y los escaneos de iris replicados por IA pueden duplicarse digitalmente si la tecnología original que aloja los datos biométricos se ha visto comprometida. Esto sirve de advertencia. Aunque el escáner biométrico sea seguro, si la representación digital de los datos biométricos se almacena de forma insegura, ya sea en otro lugar o localmente, puede ser atacada, extraída y utilizada para un futuro ataque. Recuerde que puede cambiar su contraseña, pero no sus datos biométricos. Comprender cómo se almacenan sus datos biométricos es fundamental para determinar si existe un riesgo que pueda utilizarse en su contra en el futuro mediante deepfakes.

Pasos prácticos para defenderse de los adversarios digitales actuales

Entonces, ¿cómo nos protegemos en un mundo donde la realidad percibida puede ser falsificada?

1. Implementar la verificación multimodal

Los deepfakes suelen centrarse en una sola modalidad sensorial: voz o video, como componente principal generado por la IA. Sin embargo, los humanos pueden interactuar a través de múltiples canales.

Por lo tanto, preste atención a todas las señales sensoriales. Inspeccione la voz, el rostro, las señales de comportamiento, las manos, las inflexiones tonales, el fondo, los gestos, etc., para determinar si el contenido es falso. Si una solicitud llega por video, valídela mediante una comunicación secundaria y confiable, como un mensaje de Teams o Slack, o incluso una palabra clave. Confíe, pero siempre verifique si la conexión se recibe mediante comunicaciones fuera de banda, especialmente si la solicitud es cuestionable, como una transferencia bancaria.

2. Adopte la IA para detectar la IA

Las herramientas de IA defensiva pueden entrenarse para detectar deepfakes mediante el análisis de la velocidad de fotogramas, las inconsistencias de píxeles y el parpadeo o la modulación de voz no naturales. Esto incluye la detección de vida, que busca patrones no naturales, o la ausencia de patrones naturales, en la forma en que el sujeto se mueve, habla o parpadea. Estas herramientas evolucionan continuamente a medida que lo hacen los generadores de deepfakes y están disponibles como complementos para la mayoría de las principales plataformas de comunicación unificada. En definitiva, no se trata de una defensa integral, sino de detección y respuesta activas.

3. Incorpore escenarios de deepfakes en la formación de los empleados

La formación periódica en ciberseguridad debe incluir escenarios que requieran que los empleados cuestionen las interacciones «auténticas». Esto implica que sus campañas de phishing simuladas ahora deben incluir vídeo y audio en los canales de comunicación corporativos y privados. Los mejores escenarios incluyen videollamadas falsas y mensajes de voz deepfakes.

Finalmente, fomente una cultura de desafío, donde incluso el personal directivo comprenda y acepte los obstáculos de seguridad, como las devoluciones de llamadas, la verificación de voz a texto o la autenticación multiautorización para prevenir el fraude.

4. Firme digitalmente las comunicaciones confidenciales

Use firmas criptográficas para video, audio y documentos, especialmente en industrias reguladas o donde se produzcan comunicaciones confidenciales de alto nivel. Los procesos de verificación confiables son importantes y también se pueden entrenar. Si un director ejecutivo envía un video, este debe estar firmado y ser verificable, como cualquier software firmado digitalmente, y solo debe provenir de canales de comunicación empresarial autorizados.

5. Limite su presencia en medios públicos

Cuantos menos datos de entrenamiento de IA para deepfakes pueda consumir un actor de amenazas, más difícil será crear falsificaciones convincentes. Limite la disponibilidad de imágenes, videos y muestras de voz de alta calidad, especialmente si es una figura pública o tiene una imagen pública. Evite subir contenido multimedia innecesario, elimine los metadatos cuando sea posible y restrinja el acceso a contenido de video descargable.

Además, considere agregar marcas de agua variables, tanto visibles como ocultas, a cualquier contenido para obstaculizar los intentos de entrenamiento malicioso.

Mirando hacia adelante cuando la «realidad» es incierta

La IA adversaria y los deepfakes han transformado radicalmente el panorama de amenazas. No son solo herramientas para entretener; pueden automatizar, amplificar y camuflar ataques, haciéndolos extremadamente difíciles de detectar.

Confía, pero verifica todo. La esencia de la confianza cero ya no se aplica solo a redes y dispositivos, sino también a interacciones, comunicaciones e incluso identidades. Los profesionales de la ciberseguridad deben adoptar la IA no solo para detectar y responder, sino también para anticipar y superar a los demás. Es una nueva era del viejo juego del gato y el ratón para la seguridad de nuestras organizaciones.

La defensa hoy en día ya no se trata de detener una dirección IP extranjera o un paquete malicioso; también implica cuestionar la realidad de lo que estamos experimentando. Por lo tanto, no creas todo lo que ves o escuchas, especialmente sin pruebas. El escepticismo ya no es cinismo; es la mentalidad que debes adoptar cuando la realidad misma puede ser falsificada.

Fuente: THN